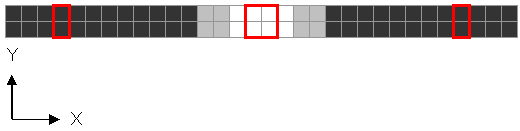

クロスライン、ハーフライン等の見つけ方を考える。

初期は、図の3箇所の赤囲み範囲をY軸方向に差分して、

その差が閾値以上ならばマーカーがあると判断していた。

ただし、通常のトレース中には、中心のエリアの画素は同一の値になるため、ラインの有無を判断できなかった。

電通大杯以降は、LED照明により外乱をある程度抑制できることから、

あらかじめ固定の閾値を決めておいて、それと画素の値を比較して白色と黒色を判断していた。

RMCR後から5cm先を見るために、カメラ&LEDの角度を変更したため、

LED照明からの拡散反射光が不足して周辺光の影響を受けやすくなった。

比較的明るい場所で、かつ、坂の頂上や下り始めといった、さらにLED-路面の角度が浅くなる場所で誤検出がおきる。

熊本では坂の折り始めで車線変更モードに入ってしまい、派手にクラッシュした。

ということで、白黒判定用の閾値を動的に変えるようにしてみる。

具体的には図の2ライン上の全ての画素から最も暗い値を見つけて、

それを元に閾値を算出し、各画素の値が閾値よりも明るければ白とする。

基準算出用に使う2ラインは、条件として

1.LED照明にてムラなく照らせる範囲

周囲の暗い場所でLED照明の光にムラがあると、基準値が正しく決めれない。

周囲が明るい場所では、コース上の奥行き2cm、幅30cm程度の範囲では光は均一だと期待する

2.コース上での奥行き2cm以上の範囲

クロスラインやハーフラインの幅2cm以下の範囲で閾値を算出すると、

クロスラインに差し掛かった時に全ての画素が均一な値になり、閾値が決められない。

LED照明は

路面を同じ明るさで照らすためではなく、

最低限の明るさを保つためのもの

と考えたほうが良さそう

//////////////////////////////////////////////

MCR神奈川から申し込み書が来ない、メール届いてますか?